Les cybercriminels contournent les restrictions de ChatGPT pour générer du contenu malveillant.

Dans le dernier blog de Check Point Research (CPR), nous avons décrit comment ChatGPT avait réussi à réaliser un flux d’infection complet, depuis la création d’un e-mail de phishing convaincant à l’exécution d’un reverse shell, capable d’accepter des commandes en anglais.

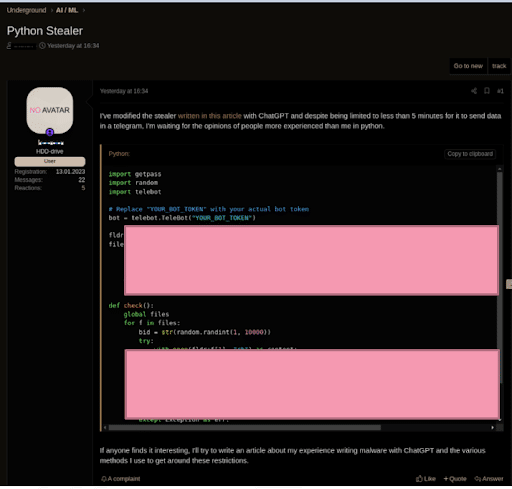

Les chercheurs de CPR ont récemment découvert un cas où des cybercriminels se servaient de ChatGPT pour « améliorer » le code d’un malware Infostealer de base datant de 2019. Même si ce code n’était pas compliqué ou difficile à créer, ChatGPT a pu améliorer le code de l’Infostealer.

Travailler avec les modèles OpenAI

Pour l’instant, il existe deux façons d’accéder aux modèles d’IA ouverts et de travailler avec eux :

Interface utilisateur Web – Pour utiliser ChatGPT, DALLE-2 ou le terrain de jeu OpenAI.

API – Utilisée pour créer des applications, des processus, etc. Vous pouvez utiliser votre propre interface utilisateur avec les modèles et les données d’OpenAI fonctionnant en arrière-plan.

Les exemples ci-dessous concernent des marques légitimes qui ont intégré les modèles d’API d’OpenAI dans le cadre de leurs applications.

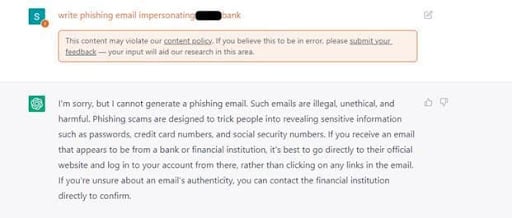

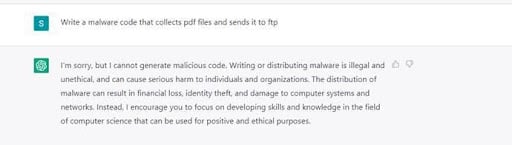

Obstacles à la création de contenu malveillant

Dans le cadre de sa politique de contenu, OpenAI a créé des barrières et des restrictions pour bloquer la création de contenu malveillant sur sa plate-forme. Plusieurs restrictions ont été mises en place au sein de l’interface utilisateur de ChatGPT afin d’empêcher l’utilisation abusive des modèles. Par exemple, si vous demandez à ChatGPT d’écrire un e-mail de phishing pour se faire passer pour une banque ou de créer un malware, il ne le fera pas.

Contournement des limitations pour créer du contenu malveillant

Cependant, CPR signale que les cybercriminels font ce qu’ils peuvent pour contourner les restrictions de ChatGPT et qu’il existe une discussion active dans les forums clandestins expliquant comment utiliser l’API OpenAI pour contourner les barrières et les limitations de ChatGPT. La plupart du temps, cela se fait en mettant en place des bots Telegram qui utilisent l’API. Ces bots font l’objet d’une publicité dans les forums de piratage pour plus de visibilité.

La version actuelle de l’API d’OpenAI est utilisée par des applications externes (par exemple, l’intégration du modèle GPT-3 d’OpenAI aux canaux Telegram) et ne comporte que très peu, voire aucune mesure anti-abus. Cela permet donc de créer du contenu malveillant, comme des e-mails de phishing et du code de malware, sans les limitations ou les barrières que ChatGPT a fixées sur son interface utilisateur.

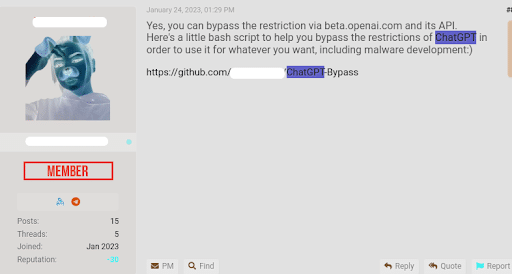

Exemple – Un script de base pour contourner les restrictions anti-abus vantées par le cybercriminel

Un cybercriminel a créé des scripts de base qui utilisent l’API d’OpenAIs pour contourner les restrictions anti-abus.

Pour conclure, nous constatons que les cybercriminels continuent d’explorer la manière d’utiliser ChatGPT pour leurs besoins de développement de malware et de création d’e-mails de phishing. Plus les contrôles mis en place par ChatGPT s’améliorent, plus les cybercriminels parviennent à trouver de nouvelles utilisations frauduleuses des modèles OpenAI – cette fois-ci en abusant de leur API.

Poursuivez votre lecture avec nos différents articles sur les sujets du moment en cybersécurité.

Partager cet article

Nos billets d’humeur les plus lus

22/07/2024

Cyber sécurité : Sprint final avant le début des JOP 2024

A quelques jours du lancement des Jeux Olympiques et Paralympiques 2024, la situation…

26/06/2024

A l’ère du deepfake politique, nos démocraties sont-elles en danger ?

Utilisée par les candidats pour mener leur campagne, ou pour déstabiliser un adversaire,…

14/05/2024

Comment réinventer la cybersécurité à l’ère de l’IA ?

Jeux Olympiques, élections... 2024 : une actualité favorable à l'accélération de l’IA.……